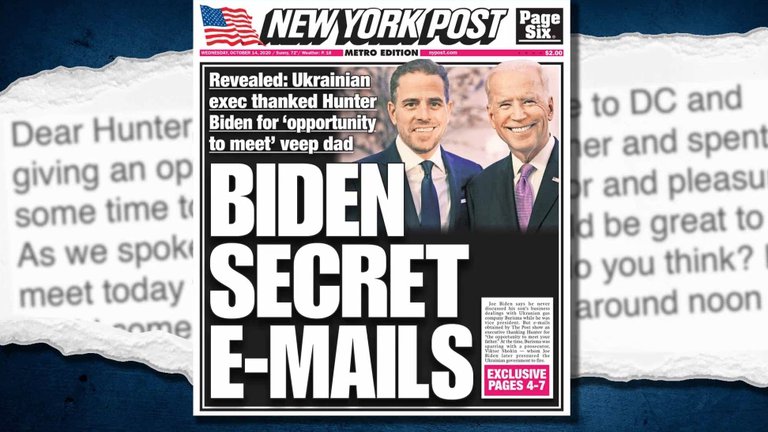

El 14 de octubre The New York Post publicó un correo electrónico en el que Vadym Pozharskyi, número tres de la empresa Burisma, habría enviado en abril de 2015 a Hunter Biden, hijo del entonces vicepresidente de los Estados Unidos: “Querido Hunter, gracias por invitarme a Washington DC y darme la oportunidad de conocer a tu padre y pasar algún tiempo con él. Es realmente un honor y un placer”. La correspondencia, básicamente, contradice al actual candidato demócrata a la presidencia, Joe Biden, quien ha negado tal encuentro como también el papel de su hijo en la gestión.

Sur Florida / infobae

La nota, desde luego, comenzó a circular en las redes sociales. Hasta que las plataformas más importantes comenzaron a aplicar sus normas de moderación de contenido contra ella. Escribió Cristina Tardáguila, experta en verificación de datos, directora asociada de Fact-Checking Network y fundadora de Agência Lupa, la primera dedicada al tema en Brasil: “Parece que Facebook y Twitter han decidido asumir la posición que durante tanto tiempo han evitado”, ironizó. “A menos de un mes del día de las elecciones, ambas compañías finalmente se convirtieron en árbitros de la verdad en internet. Son ingenuos aquellos que creen que esto no es peligroso”.

Las plataformas han repetido que son soportes abiertos al contenido ajeno, por lo cual no deben ser reguladas como los medios y, sobre todo, no pueden regular a los usuarios sin violar el derecho fundamental a la libertad de expresión. Eso las liberaría de responsabilidad sobre lo que se publica en ellas, sobre todo del discurso de odio por el que son particularmente criticadas; sin embargo, en la vida real, dado que el medio es el mensaje, el argumento deja de tener asidero para convertirse apenas en una excusa para justificar más tráfico, y por ende ganar más dinero.

Entonces, ¿cómo es posible que la publicación del Post fuera identificada como un contenido potencialmente dañino, y no se permitiera que los usuarios la compartieran?

Por la misma razón que “Facebook elimina de manera coherente la propaganda de reclutamiento de ISIS y otros grupos islámico pero ha sido mucho menos agresiva a la hora de terminar con los grupos de supremacía blanca”, explicó The New Yorker. Mientras el debate público se desorienta en conversaciones sobre si plataformas como las de Mark Zuckerberg deberían hacer más o menos por moderar o censurar el discurso discriminatorio, de odio o de violencia, nadie pregunta “cómo aplica Facebook sus reglas y quién se beneficia de ello”.

Sigue el dinero

Aunque las redes sociales insisten en que son neutrales y cualquier contenido puede circular en ellas, en la vida real no permiten la celebración del nazismo, la exhibición de cuerpos desmembrados o la imagen de un bebé con un cigarrillo en la boca, por ejemplo. Facebook tiene una suerte de política de contenidos, las “Normas de implementación”, que sus moderadores deben aplicar: un documento cambiante al que sólo accede personal selecto de la empresa, que se ofrece a los usuarios en una versión light como “Normas de la comunidad”.

La regla que allí dice “eliminamos el contenido que glorifica la violencia”, en el documento interno “enumera docenas de tipos de imágenes explícitas, como seres humanos carbonizados o quemados” y deriva a “subcategorías, definiciones técnicas y enlaces a materiales complementarios”, describió Andrew Marantz —autor de Antisocial, una investigación sobre el extremismo en línea en los Estados Unidos— en el semanario de Nueva York. Al topar con esa clase de contenidos, los moderadores deben denunciarlos como “perturbadores”.

La respuesta larga puede ser un paseo interesante por la revolución francesa, el concepto de libertad de expresión y la primera enmienda de la constitución de los Estados Unidos. La respuesta corta es una sola palabra: dinero.

“En teoría, a nadie se le permite publicar discurso de odio en Facebook. Sin embargo, muchos líderes mundiales —Rodrigo Duterte, de Filipinas; Narendra Modi, de la India; Donald Trump y otros— difunden rutinariamente discurso de odio y desinformación, en Facebook y en otros lugares”, analizó Marantz. Si la compañía les aplicara a ellos, seguidos por millones de personas, los mismos criterios que a alguien con menos de 50 amigos, “sería algo arriesgado desde el punto de vista financiero”. Como consecuencia, siguió el artículo, la red social ha errado a favor de que “los políticos publiquen lo que quieran, incluso cuando esto la ha llevado a debilitar sus propias reglas, aplicarlas selectivamente, reinterpretarlas creativamente o ignorarlas por completo”.

Dave Willner, antiguo titular de políticas de contenido de Facebook, que creó las “Normas sobre abuso” de las que se derivaron las reglas actuales, observó que para el modelo de negocio de las redes sociales no hay buenas opciones al respecto: “Censurar a los líderes mundiales podría sentar un precedente preocupante”. Pero si la posición de las plataformas de Zuckerberg es que el discurso de odio es inherentemente peligroso, ¿no sería más peligroso permitir que lo empleen precisamente aquellos que son famosos o poderosos?, argumentó el especialista que dejó Facebook en 2013 y actualmente es titular de política comunitaria en Airbnb.

Obviamente, la palabra dinero —al igual que sus vecinas fama y poder— también es la respuesta a por qué las plataformas interfirieron en la circulación del enlace a la nota del New York Post sobre Biden antes incluso de llevar a cabo la verificación de datos que podría haber establecido si el e-mail era cierto o falso: a menos de un mes de las elecciones presidenciales, es temporada de cosecha en la publicidad política de las campañas más ricas del mundo.

“No existe un enfoque perfecto para la moderación de contenidos, pero al menos podrían tratar de lucir menos visiblemente codiciosos e incoherentes”, dijo Willner, quien se convirtió en un crítico abierto a los ejecutivos de Menlo Park. Con él coincidió Rashad Robinson, presidente del grupo antiracista Color of Change: “El discurso de odio y la toxicidad se siguen multiplicando, y llega un punto en que uno dice ‘Quizá a pesar de lo que sostiene, eliminar este material no es una prioridad para ellos’”.

Marantz citó a Drew Pusateri, vocera de Facebook, al respecto: “Hemos invertido miles de millones de dólares para mantener el odio fuera de nuestra plataforma. Un informe reciente de la Comisión Europea estableció que Facebook evaluó el 95,7% de las denuncias de discurso de odio en menos de 24 horas, más rápido que YouTube y Twitter”. Y a continuación citó a Robinson que, sin objetar todo ese poder, señaló: “Sucede que lo usan mal”.

Porque eso —siguió The New Yorker— tiene poco que ver con la razón por la cual la discriminación y la violencia abundan en una red social. Encontrar el odio en las publicaciones de 3.000 millones de usuarios —la cifra combinada de Facebook, Instagram, WhatsApp y Messenger— es encontrar una aguja en un pajar, según argumentó el vicepresidente de Asuntos Globales y Comunicación de la firma de Zuckerberg, el ex viceprimer ministro británico Nick Clegg. Pero el autor de Antisocial propuso “una metáfora más honesta”: en el centro del pajar hay un poderoso imán que atrae esas agujas. Y como el imán son los algoritmos de las plataformas, también lo multiplican, porque así ganan más tracción entre los usuarios. “Elimina tantas agujas como quieras hoy, que mañana reaparecerán más. Así es como el sistema está diseñado para funcionar”.

El resto, argumentó el artículo, es sólo una cuestión de imagen. Se estima que en Menlo Park hay unos 500 empleados formales de tiempo completo en el área de relaciones públicas. Los 15.000 moderadores de contenido —que, al contrario, están vinculados por contratos y dispersos en distintas ciudades del mundo, de Dublin a Manila— denuncian las publicaciones discriminatorio o violento, pero la verdadera acción inmediata se ve cuando en la compañía se habla de un incendio de la imagen, o #PRFire. “A menudo el contenido ha sido denunciado repetidamente sin éxito, pero en el contexto de un incendio de la imagen, recibe pronta atención”, explicó la revista.

“Es un secreto a voces que las decisiones de corto plazo de Facebook están impulsadas en su mayoría por las relaciones públicas y la potencial atención negativa”, dijo Sophie Zhang, ex analista de datos que dejó la compañía en septiembre. “Antes de hacerlo”, recordó el artículo, ella publicó un memo en Workplace, la plataforma interna de los empleados de Zuckerberg, donde dijo que había sido testigo de “múltiples intentos flagrantes de gobiernos extranjeros de abusar de nuestra plataforma a gran escala”, y que en su opinión no se tomaba medidas contra ellos porque los países “no nos importaban lo suficiente como para detenerlos”, ya que no recibían atención de los medios de comunicación estadounidenses.

Al contrario, un #PRFire se debía apagar de inmediato, como cuando Facebook recibió críticas por el bullying que recibía la activista contra el cambio climático Greta Thunberg, quien sufre del síndrome de Asperger: “Los moderadores de contenidos recibieron la instrucción de aplicar una excepción ad-hoc: ‘Remover todas las instancias de ataques contra Greta Thunberg que usen los términos o los hashtags ‘Gretardada’ o ‘Retardada’”.